AMDの純正のLLMツールがあるらしい。Ryzen AIに最適化されていて、まだ対応してないが、NPUもCommingSoonで頑張ってる。気になるのでインストールしてみる。

GitHub - amd/gaia: Run LLM Agents on Ryzen AI PCs in Minutes

READMEに書いてある通り最新版のzipを落としてインストーラを使えば特に問題なくインストールできると思いきや1回実行した後、最後までいかなかったのでもう一回実行してインストールが完了した。

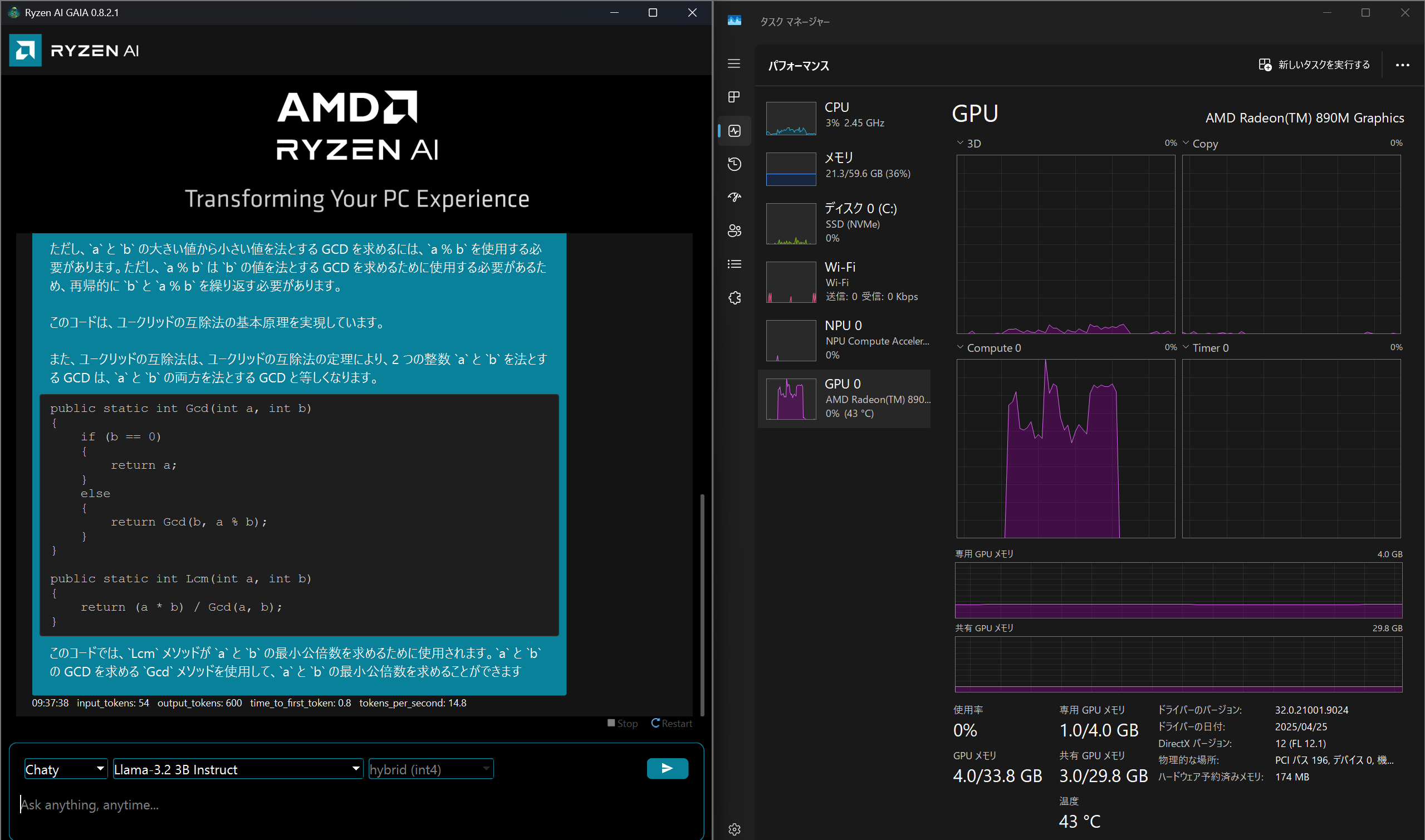

デスクトップにGAIA-UIのショートカットができていたのでそこから起動。

残念ながらモデルは専用のものを使うしかなく、そのモデルも少ない。 qwen3:8B使いたいな。

| LLM | Checkpoint | Backend | Data Type |

|---|---|---|---|

| Phi-3.5 Mini Instruct | amd/Phi-3.5-mini-instruct-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Phi-3 Mini Instruct | amd/Phi-3-mini-4k-instruct-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Llama-2 7B Chat | amd/Llama-2-7b-chat-hf-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Llama-3.2 1B Instruct | amd/Llama-3.2-1B-Instruct-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Llama-3.2 3B Instruct | amd/Llama-3.2-3B-Instruct-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Qwen 1.5 7B Chat | amd/Qwen1.5-7B-Chat-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

| Mistral 7B Instruct | amd/Mistral-7B-Instruct-v0.3-awq-g128-int4-asym-fp16-onnx-hybrid | oga | int4 |

どれも軽すぎてタスクマネージャーのグラフみても大して面白くない。

まだNPU使えないし、RadeonならLM Studioが対応してるからあえてこれ使う感じもしないなあ。